Come generare allarmi intelligenti attraverso l’anomaly detection

Allarmistica e monitoraggio vanno di pari passo. Ogni qualvolta viene utilizzato un algoritmo o una soglia per decidere se il valore attuale di un KPI registrato debba generare o meno un allarme, ci si può trovare di fronte a casistiche diverse: un problema correttamente rilevato, un’assenza di problema correttamente rilevata, un problema non rilevato o un falso allarme.

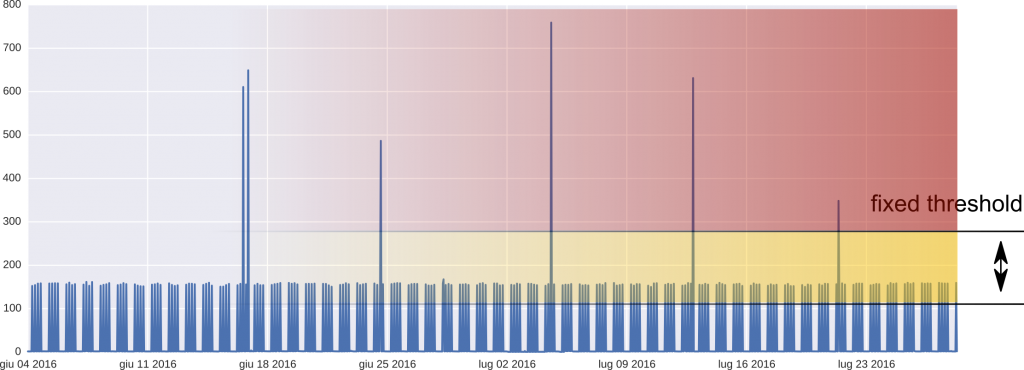

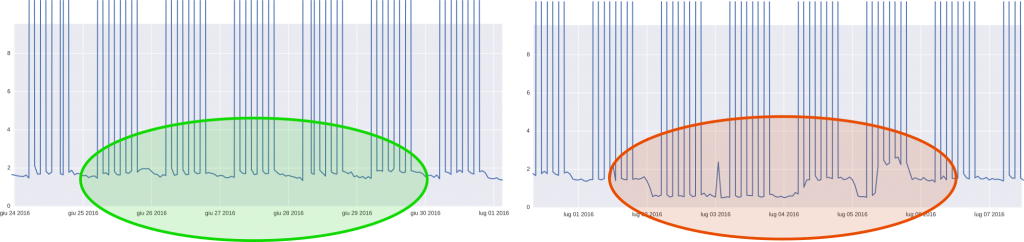

Solitamente la modalità utilizzata per generare allarmi consiste nello studiare il traffico standard – che non dovrebbe generare allarmi – e decidere delle soglie statiche in base ai dati storici e all’esperienza acquisita (come mostrato dall’esempio nella Figura 1). Ogni valore al di sotto della soglia viene considerato traffico standard mentre tutti i valori al di sopra genereranno degli allarmi. Questa modalità di creazione di allarmi in base a delle soglie definite è robusto per molti valori anomali e potrebbe essere sufficiente se la media del traffico standard non subisce delle variazioni dinamiche (in quel caso anche le soglie devono essere adattate dinamicamente). Gli allarmi potrebbero contenere anche anomalie, che sono utili per identificare problematiche e che sono totalmente diverse dai classici valori anomali. Per esempio, un cambiamento nella distribuzione (come mostrato dall’area rossa a destra nella Figura 2) può rappresentare un primo segno di instabilità e in questo caso adottare immediatamente una contromisura può prevenire che l’anomalia si trasformi in un problema reale.

Per questo motivo lo studio di meccanismi di allarmi alternativi e più sofisticati offre un valore aggiunto alla pratica comune. Riuscendo a differenziare diverse tipologie di anomalie e anche ad identificare quelle che non potrebbero essere state riscontrate dai metodi tradizionali, ci si può spingere un passo oltre nel monitoraggio delle KPIs per il traffico di rete sempre più complesso. Würth Phoenix si sta attualmente concentrando sull’analisi dei metodi statistici e di machine learning per la generazione di allarmi accurati e sempre più precisi per i clienti.

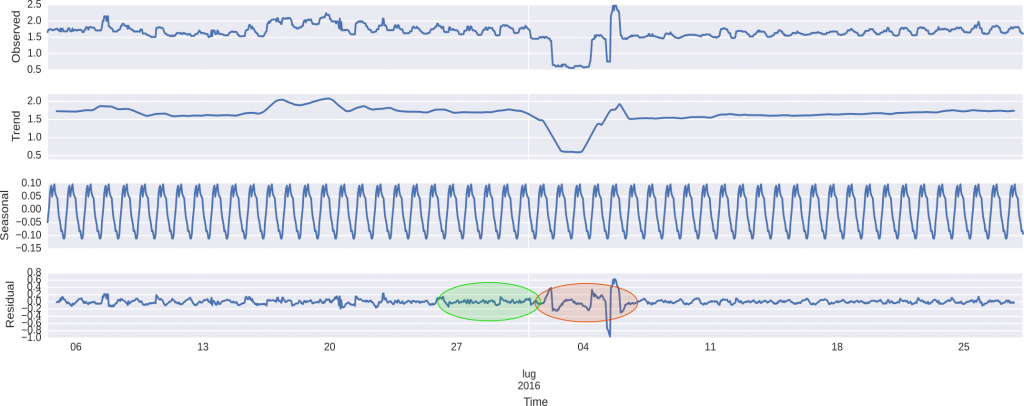

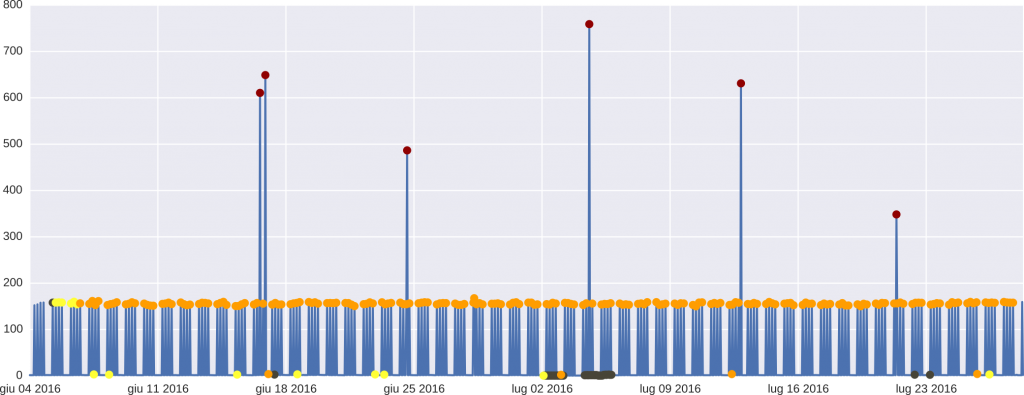

Per esempio, metodi che si basano sulla decomposizione del segnale (come mostrato sopra nella Figura 3) dove il segnale viene prima suddiviso in un trend sottoforma di componenti che si ripetono periodicamente, e lo studio delle attività residue hanno mostrato già primi risultati promettenti (vedi Figura 4 sottostante)

Come può un’analisi così sofisticata del traffico aiutare nella generazione di allarmi più intelligenti?

Specialmente quando si configurano sistemi “sconosciuti” (come nuove applicazioni o reti presso nuovi clienti), non è sempre facile identificare il comportamento standard che dovrebbero avere. È necessario del tempo per accumulare esperienza, invece il rilevamento automatico delle anomalie ha bisogno “solo” di dati (ovviamente la qualità degli allarmi migliorerà quanti più dati storici si riescano a raccogliere). La combinazione dei metodi tradizionali con quelli più nuovi è sicuramente interessante. L’utilizzo dell’anomaly detection, per esempio, può essere applicato per filtrare gli allarmi, che sono stati riscontrati attraverso l’utilizzo dei metodi tradizionali, per escludere falsi allarmi e identificare solo quelli più rilevanti – sicuramente un primo passo importante verso risultati promettenti.